This post is also available in: English (英語) 繁體中文 (繁体中国語) 한국어 (韓国語)

人工知能(AI)は至るところで利用されるようになっており、これまで考慮されることのなかったセキュリティ上の課題が生じています。AIセキュリティ体制管理(AI-SPM)は、こうした課題、たとえばAI環境内でのモデルのリスク、データ公開、潜在的な悪用などに対処するための新しい機能です。

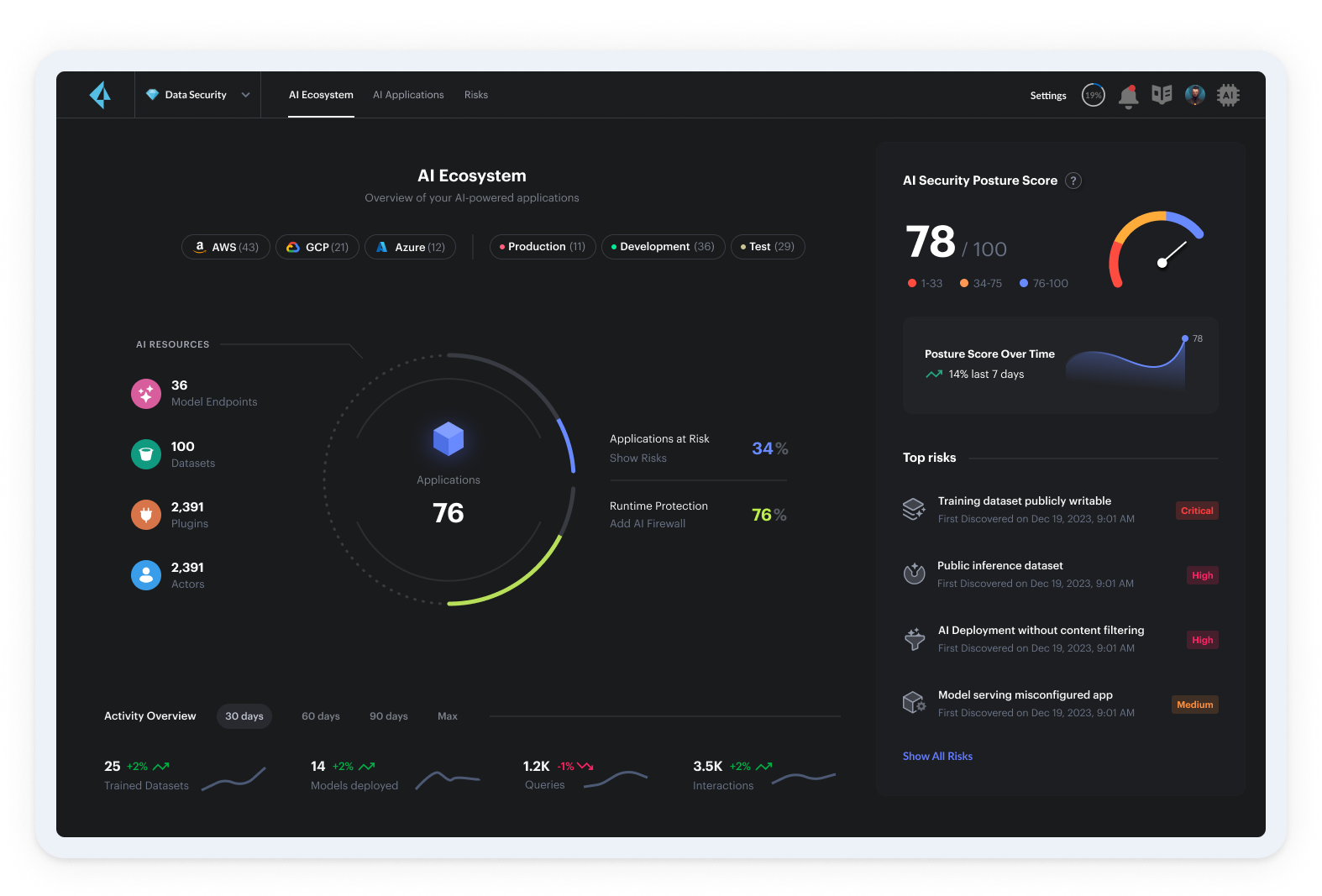

セキュリティとコンプライアンスのリスクを軽減しながらAIと生成AIを導入するという、この環境特有の課題に対処するために、弊社はこのたびPrisma® Cloud AI-SPMを発表します。

AI-SPMによるAIリスクへの対処

AI-SPMは、データ公開、悪用、モデルの脆弱性など、AI、ML、生成AIのモデルに関連した特有のリスクに対する保護を支援するために設計された、新しいツールのカテゴリーです。AI-SPMは、データ セキュリティ体制管理(DSPM)、クラウド セキュリティ体制管理(CSPM)、クラウド インフラストラクチャ権限管理(CIEM)といった既存のセキュリティ体制管理アプローチからの要素を取り入れ、本番環境でのAIシステム特有の課題に対処するために適用しています。パロアルトネットワークスでは、AI-SPMはCode to Cloud™アプローチの拡張であり、統合された一部分として認識しています。

AI-SPMツールは、データの取り込み、トレーニングから導入まで、AIモデルのライフサイクルを可視化します。AI-SPMでは、モデルの動作、データ フロー、システムでのやり取りを分析することにより、従来のリスク分析・検出ツールでは明るみに出ない可能性があるセキュリティとコンプライアンスのリスクを特定できます。組織はこれらの知見を活用してポリシーとベストプラクティスを適用できるので、AIシステムを導入する際にセキュリティとコンプライアンスが確保されます。

さらに、AI-SPMはデータ ポイズニング、モデルの窃取、不適切な出力処理といったAI特有の脅威を監視でき、潜在的なインシデントについてセキュリティ チームに警告して、修復手順に関するガイダンスを提供できます。AIに関する規制が強化される動きが続く中、AI-SPMはプライバシーと容認される使用法の考慮をAI開発プロセスに組み込むことにより、組織が先手を打ってコンプライアンス要件に対応するためにも役立ちます。

AI-SPMの主要なバックボーンは、パロアルトネットワークス独自のAIシステムであるPrecision AIで、リッチ データとセキュリティに特化したモデルを利用して検出、防御、修復を自動化することにより、セキュリティ チームがAIの出力を信頼して利用できるように支援します。パロアルトネットワークスによるPrecision AIは、セキュリティ チームのためにAIの出力に信頼性をもたらすように設計された、強力な独自AIシステムです。リッチ データの活用と、セキュリティに特化したモデルの利用により、Precision AIは検出、防御、修復のプロセスを卓越した精度で自動化します。パロアルトネットワークスの革新的なテクノロジーが、AI主導のセキュリティ ソリューションのバックボーンとなり、今日の複雑な脅威環境でのセキュリティ対策を効率化して、信頼できる結果を提供します。

AI-SPMの主な機能

AIのセキュリティは、全般的なAIエコシステムと同様に、まだ進化の途上にあります。AI-SPM、データ損失保護、データ セキュリティの間の境界線は必ずしも明確ではありません。それでも、AI-SPMソリューションの基本機能はいくつか定義できます。

1. AIモデルの検出とインベントリ作成

必要である理由: 組織の多様なチームが、管理対象、部分的に管理対象、または非管理対象のモデルを導入している場合があります。これはモデルの無秩序な拡散、モデルの不正使用、ガバナンスの欠如、シャドーAIのリスクを生みます。セキュリティ チームがAIの導入方法を監督して、使用状況の効果的な監視と、下流のリスクの防御を図る必要があります。

機能: AI-SPMツールを利用すれば、組織全体に導入されたモデルの検出、関連リソースの視覚化(コンピューティング、データ、アプリケーションなど)、AIパイプラインのエンドツーエンドの可視化が可能になります。これにより、潜在的なリスクを特定し、ガバナンス ポリシーを適用し、承認済みモデルのみが本番環境に導入されるようにすることができます。

サンプル シナリオ: 内部テストの一環として、コンテンツ ガードレールのないオープン ソースのLLMが仮想マシンに導入されます。時間の経過とともに、このモデルの使用が一般的になり、機密性の高い事例にも使用されるようになります。AI-SPMツールは、このモデルが実行されていることと、どのプリンシパルがこのモデルにアクセスしているかを検出できます。

2. データ公開防止

必要である理由: AIモデル、特にLLMは膨大な量のデータを使用してトレーニングされ、そのデータに機密情報、個人識別情報(PII)、その他の規制されたコンテンツが含まれる可能性があります。これは不注意による場合も、トレーニング データを操作してモデルに偏りや脆弱性を取り込ませるデータ ポイズニング攻撃のために生じる場合もあります。サードパーティ モデルを使用すると、このリスクがモデル プロバイダに「アウトソーシング」されるかもしれませんが、微調整や推論に組織独自のデータが使用されると、リスクが再発することが考えられます。

機密データがモデルの一部になってしまうと、検出が非常に困難になり(「ブラックボックス」問題に戻る)、通常のモデルの応答やプロンプト インジェクション攻撃を通じて公開される可能性があります。

機能: AI-SPMツールは、AIの推論およびトレーニング用データに特化して設計されたデータ検出・分類機能を備えています。これらのツールは、保護されていないストレージ バケットやデータベースなどの公開されたデータ リソースを特定でき、潜在的なデータ漏洩や不正アクセスについてセキュリティ チームに警告します。AI-SPMはまた、機密情報が意図せずAIモデルに取り込まれたり、モデルの出力を通じて公開されたりしないように、データ フローを監視できます。

サンプル シナリオ: 研究者がクラウド ストレージ バケットを使用して、新しいAIモデルのトレーニング データを保管しています。AI-SPMは、バケットに顧客のPIIが含まれていることを検出します。セキュリティ チームは警告を受け、その研究者との連携によりデータを匿名化して、データ保護規制へのコンプライアンスを確保できます。

3. 体制およびリスクの分析

必要である理由: AIシステムは複雑であり、データ パイプライン、トレーニング環境、導入インフラストラクチャなど、多数のコンポーネントを含むことがよくあります。これらのコンポーネントのいずれかに設定ミスがあったり、弱いアクセス制御が設定されていたりすれば、重大なセキュリティ リスクが生じる可能性があります。また、AIモデルは正しく保護されなければ、プロンプト インジェクション、抽出、またはサービス拒否攻撃に対しても脆弱です。最後に、強化される規制へのコンプライアンスを維持するには、継続的なモニタリングとAIシステムの評価が必要です。

機能: AI-SPMツールは、AIシステムの設定とアクセス制御を分析して、潜在的なリスクと脆弱性を特定します。たとえば、アプリ エコシステム内のデータセット、AI導入環境、クラウド リソースのセキュリティ体制を評価します。また、AI-SPMはDSPMツールと統合でき、機密情報のフローに関するコンテキスト データを取得して分析を拡充できるので、検出された脆弱性の効果的な優先順位付けが可能です。

サンプル シナリオ: AI開発チームが複数の顧客向けモデルと社内向けモデルを管理しています。アプリケーション レベルでの設定ミスが原因で、保護された知的財産にアクセスできる社内用チャットボットが一般に公開されています。AI-SPMは、モデルのAPIエンドポイントが認証なしで一般にアクセス可能であり、モデルが保護されたデータを使用していることを検出します。該当する開発チームは警告を受け、最小権限アクセス制御と認証メカニズムを実装できます。

Prisma Cloud AI-SPMの使用を開始

本番環境のAIの保護は新しい課題であり、セキュリティ チームは急速に変化する脅威環境への対処に手一杯で苦労しているときに、この課題にも取り組まなければなりません。それでも、AIの導入を妨げてAIが組織にもたらす価値をふいにしたいと思う、あるいはそのようなことができるセキュリティ リーダーはほとんどいません。

Prisma® Cloud AI-SPMなら、組織が新しいAIモデルとツールを導入する際に必要な可視性と制御が得られます。弊社のCode to Cloudプラットフォームにより、Prisma Cloudの既存のDSPM機能とCNAPP機能を基盤として緊密に統合されたソリューションが実現し、セキュリティ対策が効率化され、ツールの膨張が抑えられ、すぐに価値を実感できます。

AI-SPMがなぜ必要なのかご確認ください。デモをお申し込みください。